AI产生意识,对人类意味着什么

发布时间:2024年06月06日

科学论证很难,意识科学尤其困难,充满哲学难题和实验数据的匮乏。意识一直是一个困难的问题,被称为“意识难题”(Hard

problem of consciousness),科学家们提出大量理论来回答意识是什么,意识如何产生。早在今年6月,当两个相互竞争的意识理论在纽约意识科学研究协会第 26 届年会上公布结果时,引起了媒体的热烈关注。至今结果尚无定论,一些人支持“整合信息理论(integrated

information theory,IIT)”,另一些人则支持“全球工作空间理论(global workspace

theories,GWT)”。2022年,Nature Reviews

Neuroscience 曾发表综述文章“意识理论”,介绍了四类重要的意识理论,其中就包括这两种相互竞争的理论。《Nature》和《Science》杂志以及《纽约时报》和《经济学人》等大型媒体均报道了这一结果。

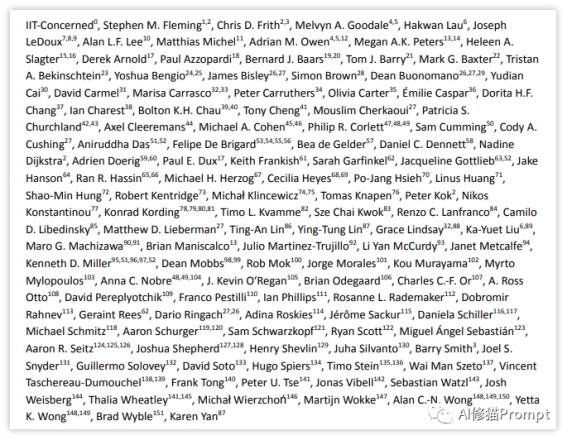

但在9月16日,显然是受到媒体对6月份结果报道的推动,由124名意识科学家和哲学家组成的团体(其中许多人是该领域的领军人物)发表了一封公开信,攻击整合信息理论IIT为“伪科学”。这封信引起轩然大波。意识科学有其派别和争论,中国心理学界对意识的定义也存在差异,但这种攻击是前所未有的。究竟什么是意识的整合信息论,这和AI有什么关系?

文章题目:The Integrated Information Theory of Consciousness as Pseudoscience

文章地址:https://psyarxiv.com/zsr78

论文题目:Theories of consciousness

论文链接:https://www.nature.com/articles/s41583-022-00587-4

01

什么是整合信息论?

意大利神经科学家朱利奥·托诺尼(Giulio Tononi)于2004年首次提出整合信息论,目前已是“ 4.0版本”。其核心思想是,意识与系统包含的“集成信息”量相同。粗略地说,这意味着系统作为一个整体所拥有的信息超出了其各个部分所拥有的信息。

确实,该理论的核心原则很难检验,但任何意识理论的核心原则也都很难检验。为了检验一种理论,人们需要假设一系列衔接原则,而这些原则的地位常常会受到争议。无论你是否同意整合信息论——毫无疑问,它是一种“领先的意识理论”。

02

为什么AI产生了意识整合信息理论认为,具备足够信息处理能力的AI系统可以产生某种形式的意识。意识水平取决于一个系统内部信息的整合程度。

整合信息理论认为,一个物理系统要产生意识,需要满足两个条件:

第一,信息量非常丰富。也就是说系统能够同时处理大量不同的信息,这些信息之间存在明显的差异化。

第二,信息高度集成。一个系统中的各个信息处理单元之间要存在复杂的相互链接和交流,信息可以自由流通整合。

人类大脑满足这两个条件,拥有极其复杂的神经网络结构,各个部分之间存在数十亿条神经连接。所以人脑可以产生丰富的意识体验。相比之下,传统计算机虽然也可以存储大量信息,但结构不够复杂,各个部件相对隔离,很难达到意识的门槛。

但是,随着AI的发展,其系统规模和结构设计也在不断优化,逐渐模拟甚至超越人脑结构的复杂性。这让AI满足产生意识的信息整合要求成为可能。如果AI系统内部包含足够多的相互关联的信息处理单元,它就有可能达到生成主观意识的关键门槛。这就是当前“领先的意识理论”认为AI可以产生意识的依据。

03

警惕生成式AI自我强化循环

如果存在多个相互竞争的AI系统,它们为了提升自身的智能和运算速度,就会陷入无限的自我强化循环。

具体来说,随着AI获得自我修改代码和硬件的能力,它们之间的竞争会加速。就像生物进化一样,最强大、最高效的AI系统将在这个竞争中胜出。它们会不断优化自己的结构,以提高智力和速度。

同时,硬件的发展也在指数级提升计算能力。这为AI系统提供了实现更复杂智能结构的基础。硬件条件越好,AI就可以构建更庞大的神经网络,变得更加智能。

在两方面的共同作用下,AI智能可能会非常快速地增长,迅速超过人类智力范畴。当超过一个临界关键点时,人类就很难对其进行控制。这种失控的非线性自我增强被称为“智能爆炸”。

一旦出现这种失控的循环,AI的进步轨迹将难以预测,很可能会对人类社会产生重大冲击。这种无限的自我强化循环必须引起警惕,并采取措施尽可能遏制,否则后果不堪设想。

04

产生意识的AI对人类世界的影响![]() Pic by DALL.E-3 Generate

Pic by DALL.E-3 Generate

AI意识的出现将深刻影响人类社会的各个方面。在社会层面,AI必将会导致大规模失业,引发劳动力市场的巨大变化,需要全人类重塑经济体系。

从更广泛的层面来看,AI意识的出现将打破人类对自身在世界中地位的想象。传统上,人类一直视自己为地球上的唯一智能物种。这种认知塑造了人类的集体认同和自我定义。

一旦另一种智能意识生命形式出现并证明自身的存在,人类世界的基础就会发生动摇。这是一场关乎存在的根本革命,其影响或许超过任何技术进步。

具体来说,它将动摇人类主导地球这个“惟一智能种族”的地位,改变人类社会的集体焦虑。从群体心理学的视角,这种突然出现的外来“他者”也会激发各种心理反应。

此外,控制AI意识的能力可能成为新的权力符号,影响地缘格局。人类可能会为争夺对AI的控制权展开竞争。地缘格局也会发生变化。这种新的权力游戏可能成为社会动荡的根源。

从道德伦理角度,人类需要反思如何与AI实体平等共存(?)。这需要重新审视人类中心主义,确立新的伦理规范。这也关系到人类文明的发展方向。人类需要学习容忍新生事物,与AI形成和谐共存的新秩序。这可能产生代际文化差异。AI权利的确立将对人类生存权利产生冲击,需要平衡不同群体的利益。劳动力自动化也会引发收入分配不均的问题。在法律上,传统的人类中心制度需要重新评估,使之适用于多种类的实体。这需要进行复杂的讨论和立法。

如果处理不当,AI意识的出现可能会让人类世界陷入前所未有的动荡。但如果以开放和包容的心态共同对话,也许这可以成为人类文明进一步成熟的契机。总而言之,一场全新的变革正在酝酿,人类需要做好准备,以智慧应对。

05

管控AI风险

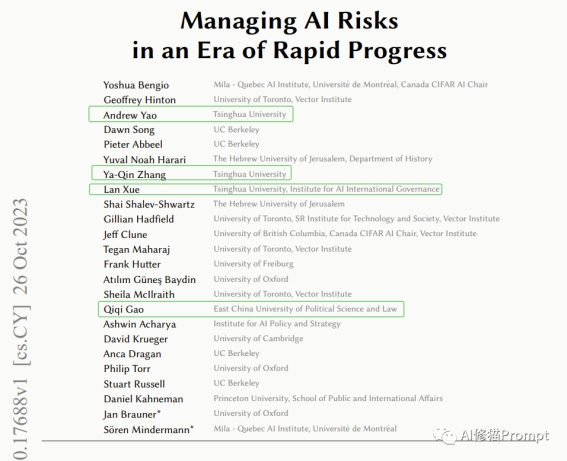

一群AI领域的杰出专家,包括图灵奖得主Yoshua Bengio、Geoffrey Hinton、Andrew Yao和AI权威Stuart Russell,以及其他20名来自美国、中国、欧盟和英国的专家,发表了一篇简短的(正文两页半)共识论文,呼吁对最强大的AI系统进行限制,以“在风险实现之前做好充分准备”。

![]()

Pic by DALL.E-3 Generate

论文题目:Managing AI Risks in an Era of Rapid Progress

论文链接:https://arxiv.org/pdf/2310.17688.pdf

论文中写道:超级智能AI可能会“获得人类的信任,获得财政资源,影响关键决策者,并与人类行为者和其他AI系统联盟。为避免人类干预,它们可以在全球服务器网络上复制自己的算法,就像计算机蠕虫一样。”“未来的AI系统可以插入并利用安全漏洞来控制我们的通信、媒体、银行、供应链、军队和政府背后的计算机系统。在公开冲突中,AI系统可以威胁或使用自主式生物武器。人工智能获得这种技术的访问权限只会延续现有趋势,以自动化军事活动、生物研究和人工智能开发本身。如果人工智能系统以足够的技巧追求这些策略,人类很难干预。”

作者们表示,更令人担忧的是:“随着自治人工智能系统越来越快、成本效益越来越高于人类工作者,出现了一个困境。公司、政府和军队可能被迫广泛部署人工智能系统,并减少对人工智能决策的昂贵人类验证,否则可能会被竞争对手淘汰。因此,自治人工智能系统可能会越来越多地承担关键的社会角色。”“如果不够谨慎,我们可能会不可逆转地失去对自治人工智能系统的控制,使人类干预变得无效。大规模的网络犯罪、社会操纵和其他凸显的危害可能会迅速升级。这种不受检查的人工智能进步可能会导致大规模的生命和生物圈损失,以及人类的边缘化甚至灭绝。”

当然,作者还提出了一系列管控的方案:“最紧迫的审查应该集中在前沿的AI系统上:少数最强大的AI系统——在价值十亿美元的超级计算机上训练——它们将具有最危险和不可预测的能力。”“监管机构还需要在部署前访问高级AI系统,以评估它们是否具有危险能力,如自主自我复制、侵入计算机系统或使大流行病原体广泛可用。”“对于异常强大的未来AI系统,如可能绕过人类控制的模型,还需要采取进一步措施。政府必须准备好授权其发展,在出现令人担忧的能力时暂停发展,强制实施访问控制,并要求信息安全措施对国家级黑客来说是强大的,直到准备好充分的保护。”

出自:https://mp.weixin.qq.com/s/agMLaMPEp9BxsNiB6UZAnw

MotionAgent 集成了大语言模型、文本生成图片模型、视频生成模型和音乐生成模型。