最强开源数字人对口型系统介绍

发布时间:2024年06月06日

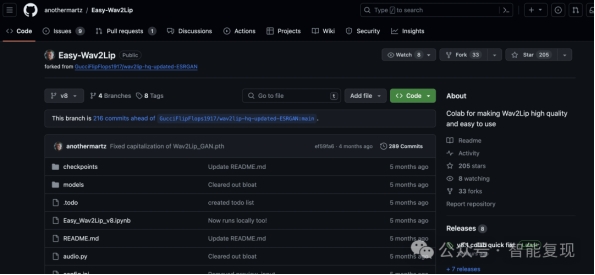

大家好,今天给大家介绍的是开源“最强”的数字人克隆方法 Easy-Wav2Lip:

仓库地址:

https://github.com/anothermartz/Easy-Wav2Lip/

说他最强,指的是跟同类开源方法做对比,对口型时候无需额外训练,清晰度比当前开源的更好。使用过原版开源的Wav2Lip的都知道,原作者使用分辨率很低的图像数据集训练的模型,嘴部特别清晰,基本没啥价值,但是 这个框架和算法倒是不错,如果想得到高清模型,得付出相当大的精力去收集高清数据集从头训练,而且 还不一定能成功,所以这个项目让无数工程师“竞折腰”。

一种折中的办法是在原模型生成的视频基础上加上高清后处理,但是得到的结果有几个问题:嘴部不自然,视频质量不高,计算复杂度太高等。

这里介绍的方法也是采用的后处理方式,但是相比前面的高清处理效果又好一些,同时优化了推理速度。该方法提供了3种推理模型:

原始模型,改进模型和增强模型。原始模型跟原来Wav2Lip一样。改进模型有所改观,但是仍然很模糊,只是推理速度比较快,经过测试大概跟原视频时长1:1的样子。而增强模型虽然质量有所改善,但是 推理速度还是比较慢,经过测试大概在1:5左右。想用在实时互动场景使用,看来还是让大家失望了,但是在非实时场景,还是有用武之地的。

话不多说,

我们直接看效果

,时长00:25

这个是改进版,但还是模糊的,然后再看一个增强的:

,时长00:25

增强版相比改进版要清晰多了,口型同步的也不错。在很多场景下基本上是能够满足使用,如果不追求特别高清的话,能够做到这一点,已经很了不得了,关键是开源。

为了让大家能够体验这个代码,我们第一时间把这个系统推到在线服务。网站地址:

https://www.mindtechassist.com/

口型同步提供了两个:一个是本文介绍的试验版本,另一个是稳定版本。

使用的时候在这里面输入密钥,然后再上传一个音频和一个视频。声音用于驱动视频,生成新的对口型视频。

要求:

声音时长和视频时长等长;

视频分辨率不超过1080P,帧率不超过30;

音频为单人声,噪音降到最低;

视频为单人露面视频,脸部清洗,每一帧都要有人脸。

出自:https://mp.weixin.qq.com/s/HZejVHOPervTGCAN1w5zmA

青柠设计是一款免费在线设计工具,主打海报在线设计,覆盖常见的设计样式,五分钟在线完成设计。